Watch Dogs Legion: Ray Tracing e prestazioni con 15 schede video

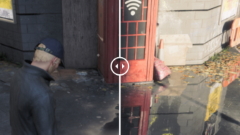

Con Watch Dogs: Legion, NVIDIA e Ubisoft portano avanti la loro collaborazione che ormai perdura da qualche anno. In particolare, il nuovo titolo a mondo aperto supporta riflessi in Ray Tracing e DLSS che, tramite tecnologie di intelligenza artificiale, gestisce il super sampling di bordi e texture per migliorare la qualità e le prestazioni

di Pasquale Fusco , Rosario Grasso , Manolo De Agostini pubblicato il 26 Novembre 2020 nel canale VideogamesUbisoftNVIDIAGeForceAMDRadeon

Fortnite: ecco com'è in Ray Tracing, e con quali prestazioni

Fortnite: ecco com'è in Ray Tracing, e con quali prestazioni Crysis Remastered alla prova, anche con RTX 3090. E lascia l'amaro in bocca

Crysis Remastered alla prova, anche con RTX 3090. E lascia l'amaro in bocca Microsoft Flight Simulator come Crysis? Provato con 9 schede video

Microsoft Flight Simulator come Crysis? Provato con 9 schede video Recensione Samsung Galaxy Z Fold7: un grande salto generazionale

Recensione Samsung Galaxy Z Fold7: un grande salto generazionale  The Edge of Fate è Destiny 2.5. E questo è un problema

The Edge of Fate è Destiny 2.5. E questo è un problema Ryzen Threadripper 9980X e 9970X alla prova: AMD Zen 5 al massimo livello

Ryzen Threadripper 9980X e 9970X alla prova: AMD Zen 5 al massimo livello Identikit della scheda video perfetta, pensieri tra il serio e il faceto

Identikit della scheda video perfetta, pensieri tra il serio e il faceto SUV, 100% elettrico e costa meno di un benzina: Leapmotor B10 disponibile in Italia

SUV, 100% elettrico e costa meno di un benzina: Leapmotor B10 disponibile in Italia Hai mai caricato un referto su ChatGPT? Hai messo in grave pericolo la tua salute e la tua privacy

Hai mai caricato un referto su ChatGPT? Hai messo in grave pericolo la tua salute e la tua privacy Apple vuole un nuovo campus nella Silicon Valley. Apple Park non basta più

Apple vuole un nuovo campus nella Silicon Valley. Apple Park non basta più DJI Osmo 360, la nuova action cam a 360° usa un sensore quadrato e registra in 8K

DJI Osmo 360, la nuova action cam a 360° usa un sensore quadrato e registra in 8K  Lo strumento anti-requisiti per Windows 11 cambia identità: ecco il nuovo nome di Flyby11

Lo strumento anti-requisiti per Windows 11 cambia identità: ecco il nuovo nome di Flyby11 Utenti di Claude in rivolta: 'I bei vecchi tempi sono finiti'

Utenti di Claude in rivolta: 'I bei vecchi tempi sono finiti' Rocket Lab Mars Telecommunications Orbiter: un nuovo satellite per comunicare con Marte

Rocket Lab Mars Telecommunications Orbiter: un nuovo satellite per comunicare con Marte NVIDIA GeForce RTX: supporto driver su Windows 10 fino a ottobre 2026

NVIDIA GeForce RTX: supporto driver su Windows 10 fino a ottobre 2026 iliad ha iniziato a vendere smartphone dalle SIMBOX: anche iPhone ricondizionati a 169€

iliad ha iniziato a vendere smartphone dalle SIMBOX: anche iPhone ricondizionati a 169€ La cinese SatNet ha lanciato un nuovo gruppo di satelliti Guowang per la connettività Internet

La cinese SatNet ha lanciato un nuovo gruppo di satelliti Guowang per la connettività Internet Cloud sovrano europeo: a che punto siamo con il progetto SECA API? Ne parliamo con Aruba e IONOS

Cloud sovrano europeo: a che punto siamo con il progetto SECA API? Ne parliamo con Aruba e IONOS  The Medium arriverà al cinema grazie al produttore di It e Annabelle

The Medium arriverà al cinema grazie al produttore di It e Annabelle Addio alle faccende domestiche? Il robot che fa il bucato è già tra noi!

Addio alle faccende domestiche? Il robot che fa il bucato è già tra noi!

66 Commenti

Gli autori dei commenti, e non la redazione, sono responsabili dei contenuti da loro inseriti - infoper quello che cerchiamo noi da ormai un ventennio si dovrà aspettare almeno altri 10 anni con un path treacing e una costruzione dettagliata delle scene...

parliamo di almeno 5 generazioni e 3 o 4 volte la potenza computazionale di oggi.

c'era chi sosteneva che per il path tracing fotorealistico sarebbero stati necessari al minimo 100TF.

se prendi la 6800 xt a riferimento, non è un valore distante da quello stimato.

quindi simulazioni poco accurate ed effetti vari che eseguono trucchi per semplificare il calcolo li vedrai per molto tempo ancora.

forse oggi lo potrest fare con 4 schede in mGPU, ma non lo vedo molto remunerativo per una SH... venderebbero 2 copie.

Gioco ai giochi anni 90 con schermo catodico oltre ai giochi recenti e non cerco certo il fotorealismo: ho adorato lo stile di Dishonored, per esempio

Quindi no non sto a guardare i dettagli delle pozzanghere mentre fraggo, ma se mi si mettono di fronte delle foto per fare paragoni, ovvio, arrivo a qualche considerazione

Ad esempio le differenze un po' troppo marcate

Sto solo riflettendo sul paradosso di chi loda eccessivamente queste implementazioni, soprattutto a dispetto di altre che vengono giudicate non realistiche

Continuo a ribadire che imho finora sono solo effettini e che spero si vada ad utilizzare in maniera un po' più consistente l'rt

E si ci vorrà un po' ma intanto osservo volentieri (edit: i progressi, come sempre fatto fin dal zx spectrum)

Una supercazzola per non dire che il DLSS è un upscaling inventato per nascondere la pesantezza di RT ?

E per quanto l'upscaling sia intelligente e studiato la perdita di dettaglio c' è e si vede, basta guardare l' effetto lavatrice sulle immagini.

Esatto! Onestamente sono su PC da secoli e ho sempre avuto schede sia AMD che Nvidia, però mi vergogno a leggere i commenti dei PC Enthusiasts (chiamiamoli così

Anni a prendere in giro le console perchè upscalavano da 1440 (o quello che era) a 4k e ora che Nvidia arriva con sta cosa da super sfigati, tutti a dire "wooooow fantastico, per il 4k ci vuole il DLSS!1!!1!!!!"

Nvidia per me è la classica azienda in grado di creare vere e proprie sette di adepti stile Apple, che non riescono manco più a dare un valore coerente al prodotto che comprano o capire tutte le frottole che propinano loro.

Quindi Poi The Last of Us non fa nessun riflesso ma dei trucchi artistici per darti l'impressione visiva che ci siano ma in realtà non esistono.

Ah certo perchè qui stiamo facendo studi di fisica applicata vero?? Ma che ti frega come fanno i riflessi, l'importante è che rendano bene e mi spiace dirlo le esclusive su console soprattutto quelle Sony rendono meglio molte volte di giochi su PC con GPU super pompate. Certo meno frames, meno questo e meno quello, intanto però rendono meglio.

Se RayTracing invecchia male come PhysiX siamo a posto... io purtroppo ho avuto la sfortuna di rigiocare Batman Arkham City e avendo scheda Nvidia ho attivato PhysiX, una porcheria, inguardabile oggi giorno. Si vede proprio che hanno fatto un lavoro scandaloso, tipo effettini buttati li così giusto per fare i fichi... Tristezza.

Anni a prendere in giro le console perchè upscalavano da 1440 (o quello che era) a 4k e ora che Nvidia arriva con sta cosa da super sfigati, tutti a dire "wooooow fantastico, per il 4k ci vuole il DLSS!1!!1!!!!"

Nvidia per me è la classica azienda in grado di creare vere e proprie sette di adepti stile Apple, che non riescono manco più a dare un valore coerente al prodotto che comprano o capire tutte le frottole che propinano loro.

Se solo lo rendessero compatibile con il mio A10-7800 lo userei per arrivare al fullhd per i giochi in cui non ci arriva, altro che 4k

E lo vedo interessante anche per le console, switch incluso

Perché non è upscaling

sono 2 cose molto divere upscalare è dlss fanno le cose in modo diverso e con diversi risultati.

Io continuo a prendere in giro le console ma userei il dlss tutta la vita

Lo è

Che sia "intelligente" e quindi migliore di un upscaling bovino perché si è pappato qualche migliaio di frame del videogioco e quindi ha un' idea di massima di cosa ci dovrebbe essere nell' immagine e cerca quindi di ricostruirla meglio è assolutamente vero

Ma è e resta un upscaling, l'immagine viene renderizzata a risoluzione inferiore e poi ricostruita a risoluzione superiore sulla base di una rete neurale allenata sulle immagini tipiche del videogioco.

Io continuo a prendere in giro le console ma userei il dlss tutta la vita

Ah è vero usano il "Deep Learning" scusa!! Invece sulle console avranno usato lo "Stupid Learning" no? Ma dai siamo seri, io ho visto i 4k upscalati su console andavano benissimo, onestamente differenza impercettibile, però gente che da anni tirava palate di sterco su sta cosa.

Arriva Nvidia che per carità avrà creato un algoritmo incredibile in grado di fare anche i viaggi nel tempo, però sempre di upscaling si parla eh.

Oppure qualcuno vorrebbe dirmi che il DLSS è come la risoluzione nativa, perchè ad occhio per me si poteva dire lo stesso su console, cioè se andiamo a spanne, se così si può dire.

Arriva Nvidia che per carità avrà creato un algoritmo incredibile in grado di fare anche i viaggi nel tempo, però sempre di upscaling si parla eh.

Oppure qualcuno vorrebbe dirmi che il DLSS è come la risoluzione nativa, perchè ad occhio per me si poteva dire lo stesso su console, cioè se andiamo a spanne, se così si può dire.

io ero serio infatti la differenza vissiva è netta, se non ti dico che ho attivato il dlss è impossibile che tu te ne possa accorgere invece con immagini upscalate è molto facile vedere la differenza perché hai una perdita di dettaglio.

Anche con il DLSS hai perdita di dettaglio, solo che è sostituito da dettagli ricostruiti artificialmente.

La IA ricostruisce un'immagine "verosimile", un po'come fa con i volti antichi :

https://www.dday.it/redazione/36650...peratori-romani

La differenza tra il normale upscaling e il DLSS sta tutta lì, normalmente i dettagli sono persi, col DLSS invece si mettono dettagli più o meno verosimili inventati sul momento.

Guarda che non era l'upscaling del monitor eh, su console il segnale usciva in 4k e veniva upscalato internamente, ti dico che per me anche in quel caso era difficile vedere la differenza ad occhio nudo, mica parliamo di scaling da 4 soldi. Per dire che sta cosa c'era da anni, poi che Nvidia abbia migliorato e usato misteriosi algoritmi di "Deep Learning" ok, ma non griderei al miracolo...

Semplicemente hanno tirato fuori una tecnologia il Ray Tracing che manco le loro schede video riescono a far girare. E allora hanno copiato quello che si faceva su console da anni. Geni!!!

Che sia "intelligente" e quindi migliore di un upscaling bovino perché si è pappato qualche migliaio di frame del videogioco e quindi ha un' idea di massima di cosa ci dovrebbe essere nell' immagine e cerca quindi di ricostruirla meglio è assolutamente vero

Ma è e resta un upscaling, l'immagine viene renderizzata a risoluzione inferiore e poi ricostruita a risoluzione superiore sulla base di una rete neurale allenata sulle immagini tipiche del videogioco.

Volendo essere precisi è super sampling intelligente e non gravoso ma vabbè sono dettagli immagino

Sennò è come dire che la birra è acqua, non so se ci capiamo

Devi effettuare il login per poter commentare

Se non sei ancora registrato, puoi farlo attraverso questo form.

Se sei già registrato e loggato nel sito, puoi inserire il tuo commento.

Si tenga presente quanto letto nel regolamento, nel rispetto del "quieto vivere".