Xbox One Slim a fine anno, modello più potente solo nel 2017

Secondo i rumors Microsoft avrebbe in programma di lanciare anche una versione con hardware potenziato nel 2017.

di Davide Spotti pubblicata il 26 Maggio 2016, alle 08:25 nel canale VideogamesMicrosoftXbox

Recensione REDMAGIC Astra Gaming Tablet: che spettacolo di tablet!

Recensione REDMAGIC Astra Gaming Tablet: che spettacolo di tablet!  Dopo un mese, e 50 foto, cosa abbiamo capito della nuova Nintendo Switch 2

Dopo un mese, e 50 foto, cosa abbiamo capito della nuova Nintendo Switch 2 Gigabyte Aero X16 Copilot+ PC: tanta potenza non solo per l'IA

Gigabyte Aero X16 Copilot+ PC: tanta potenza non solo per l'IA Riportare in vita un uccello gigante estinto della Nuova Zelanda: il sogno del regista Peter Jackson

Riportare in vita un uccello gigante estinto della Nuova Zelanda: il sogno del regista Peter Jackson GlobalFoundries vuole fare i chip? La verità dietro l'acquisizione di MIPS

GlobalFoundries vuole fare i chip? La verità dietro l'acquisizione di MIPS Le offerte Amazon del weekend fan tremare la concorrenza: tablet, monitor, iPhone, PC, robot e altri articoli

Le offerte Amazon del weekend fan tremare la concorrenza: tablet, monitor, iPhone, PC, robot e altri articoli Dopo l'abbuffata del Prime Day ci sono ancora robot aspirapolvere a prezzi imbattibili: ecco l'elenco completo

Dopo l'abbuffata del Prime Day ci sono ancora robot aspirapolvere a prezzi imbattibili: ecco l'elenco completo The Witcher IV non è ancora uscito, ma sta già facendo volare CD Projekt RED

The Witcher IV non è ancora uscito, ma sta già facendo volare CD Projekt RED Videosorveglianza 4K e batteria solare: Arlo Ultra 2 in offerta su Amazon in due versioni da paura

Videosorveglianza 4K e batteria solare: Arlo Ultra 2 in offerta su Amazon in due versioni da paura A 179€ è imbattibile: tablet 11" 2,5K, 8GB/512GB, 8580mAh, Helio G99 e anche LTE, sceso di 50€

A 179€ è imbattibile: tablet 11" 2,5K, 8GB/512GB, 8580mAh, Helio G99 e anche LTE, sceso di 50€ Monitor da urlo in offerta su Amazon: tra OLED, 240Hz e schermi curvi c'è l'imbarazzo della scelta

Monitor da urlo in offerta su Amazon: tra OLED, 240Hz e schermi curvi c'è l'imbarazzo della scelta Il boom azionario di NVIDIA sta rendendo straricchi molti dei suoi dipendenti

Il boom azionario di NVIDIA sta rendendo straricchi molti dei suoi dipendenti Elegante, senza cornici, 91€: in offerta il monitor HP 524sa, 23,8" full HD perfetto per casa e ufficio

Elegante, senza cornici, 91€: in offerta il monitor HP 524sa, 23,8" full HD perfetto per casa e ufficio ZX Spectrum: quali erano i 10 giochi più belli

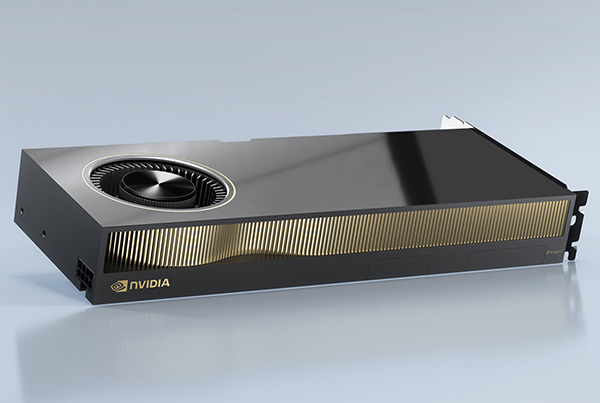

ZX Spectrum: quali erano i 10 giochi più belli GPU NVIDIA vulnerabili a GPUHammer: l'attacco Rowhammer adesso non prende di mira solo le DRAM

GPU NVIDIA vulnerabili a GPUHammer: l'attacco Rowhammer adesso non prende di mira solo le DRAM Ecco come Elon Musk intende controllarvi con la sua IA: la verità su Grok 4

Ecco come Elon Musk intende controllarvi con la sua IA: la verità su Grok 4

59 Commenti

Gli autori dei commenti, e non la redazione, sono responsabili dei contenuti da loro inseriti - infoIn che senso? Perché a livello di potenza di calcolo non c'era nessuna CPU che poteva competere.

Poi che ci fossero problemi per sfruttarla è un altro paio di maniche.

No, come ti è stato detto non c'era niente. Inoltre la GPU della XBox360 aveva persino delle funzionalità di hardware tessellation che sarebbero state introdotte soltanto con le DirectX11 su PC.

Col nuovo hardware il FullHD a 60FPS sarà finalmente abbordabile. Pure con modelli poligonali un po' migliorati, se le voci che circolano saranno confermate.

Lo penso anch'io, ma è stato anche molto comodo per Ati, perché ha potuto riciclare ricerca & sviluppo fatti per la GPU della XBox360, per le nuove GPU per PC.

Non ci sarà nulla del genere: ormai si va avanti a colpi di più shader core, e frequenze più elevate (se/quando possibile).

Io l'ho sempre detto, la Ps4 ha portato, nel momento in cui e' uscita, la migliore APU possibile.

Veramente tuttodigitale non ha detto nulla del genere.

Ha parlato della sola GPU, e peraltro soltanto di quella della PS3.

E' regredita, semmai, visti i risultati.

L'Xbox 360 e' uscita a Novembre 2005, l'XBOX ONE a Novembre 2013

La Ps3 e' uscita nel Novembre 2006, la Ps4 nel Novembre 2013

Quindi , come ho detto prima, non sono 10 ma neanche 4/5.

Sono 7/8 anni.

Sì, 8 e 7 anni rispettivamente.

Perché così le console diventeranno a tutti gli effetti dei PC: cambio di hardware dopo pochi anni.

FullHD a 60FPS dovrebbero essere tranquillamente gestibili. Non so 2K, visto che ci sono un bel po' di pixel in più da processare.

Lato GPU non ci sarebbe alcun problema. Al momento il collo di bottiglia è rappresentato dalla CPU, che tante volte non è sufficiente per garantire una certa fluidità.

Solo che se aumenteranno soltanto di qualche decina di punti percentuali la frequenza dei core della CPU, le problematiche non saranno risolte, ma soltanto leggermente migliorate.

Il case lo devi ridisegnare in funzione di immettere l'aria e di estrarla.

Poi le ventole devi metterle buone, se no fa casino.

Certamente. Infatti anche la Wii U fa casino, pur avendo hardware ben inferiore.

Ne abbiamo già parlato: di circa $100 all'introduzione, ma dopo appena un anno Microsoft guadagnava circa $75 per ogni console venduta.

E anche la complessità, non era certo paragonabile:

384 milioni vs 220milioni..(molto meglio di PS3 sia chiaro, che è uscita con colpevole ritardo).

Xenos aveva anche 10MB di eDRAM, più un bel po' di milioni di transistor per un po' di logica "tipo ROP".

Imho, più che demeriti di ATI (un disegno unificato dx10, è per sua natura meno efficiente di quello dx9 con shader dedicati con codice legacy), credo che sia stata nvidia a piazzare il colpo..

Non credo, visto che tanti sviluppatori sono stati costretti a utilizzare Cell per scaricargli un po' di effetti di postprocessing, per cercare di scaricare un po' di calcoli dalla GPU, che aveva già il suo bel da fare.

Sì, ma non perdeva nemmeno tanto: vedi sopra.

E' Sony con la PS3 che s'è svenata, visto che ha voluto strafare, con l'integrazione dell'inutilissimo lettore BluRay in pompa magna, che le è costato un occhio della testa, ma soprattutto il ritardo di un anno per i problemi di approvvigionamento dei pick-up del laser.

avevano anche un mostro di CPU, un tri-core da 3,2GHz..

No, Xenon era "una carretta", citando testualmente lo sviluppatore di Fable 2, che è stato utente di questo forum. Se cerchi quelli dell'utente fek, ci sono un sacco di commenti che ha scritto all'epoca, e in cui si è lamentato della scarsa potenza di calcolo della CPU della XBox360.

Per la GPU il discorso era, invece, molto diverso, ma affermava che per sfruttarla adeguatamente bisognava cambiare il modo di programmarla, rispetto a una tradizionale GPU per PC. Anche questo l'ha scritto qui, da qualche parte.

Sì.

Esattamente, ma anche la CPU della XBox360 era in-order.

Sì, servivano 3 passaggi per renderizzare a 720p@30FPS con AA 4x, se non ricordo male.

Come sempre, ma meglio delle precedenti console.

Forse a parte la prima XBox, che fra quelle vecchie è la più semplice da programmare. Ma c'è da dire che era anche di gran lunga più costosa.

Mi permetto di dissentire, e ho già ampiamente spiegato il perché.

La XBox360 costava soltanto $100 in più, ma... a Microsoft, e non agli utenti.

Poi c'è da dire che la XBoxOne ricalca un po' quello che è stato fatto con la XBox360, avendo anche lei memoria embedded, e dunque costringendo i programmatori a fare i salti mortali per spremerla per bene.

la edram non la considero, pechè è semplicemente un modo per risparmiare, sulle ram e sul pcb..se no cosa si fa, misuriamo anche le dimensioni totale dei chips montati su r580?

forse hai equivocato. Tu parli di PS3, e quindi di g70/1, che era un bel pò più lento con filtri attivi di r580.

Su questo sono d'accordo, il mostro era riferito al consumo. Era affamato di energia.

Il modello Falcon (90nm GPU, 80nm edram e 65nm CPU) assorbiva 120W contro i 175W del modello originale...

Quindi non consideri nemmeno l'ESRAM della XBoxOne? Se fai il conteggio dei transistor del SoC, togli quelli per questo componente?

Comunque l'eDRAM nella GPU della XBox360 serviva come framebuffer & zbuffer (se non ricordo male), ed era necessario per il rendering della scena assieme alla logica di cui sopra (che gestiva ROP, AA, e HDR).

Si tratta di un componente che fa parte della GPU, anche se è staccato (poi integrato nella versione singolo chip, e infine singolo SoC), ed è ben diverso dalla normale RAM (infatti c'è anche un bel po' di logica).

si...lo sai meglio di me che la ESRAM è una soluzione di ripiego, a basso costo, rispetto ad una soluzione basata sulle gddr5.

Ma l'eDRAM della XBox360 non serviva solo a quello, visto che c'era anche la logica delle ROP + AA + HDR. Xenos è nato per lavorare in un certo modo, molto diverso dalle normali GPU.

Ma l'eDRAM della XBox360 non serviva solo a quello, visto che c'era anche la logica delle ROP

di questo fatto ne ero all'oscuro.

Io l'ho sempre detto, la Ps4 ha portato, nel momento in cui e' uscita, la migliore APU possibile.

ho detto un qualcosa di poco diverso....

se si dà contro alla ps4 lato GPU, non si può non trascurare il fatto che la ps3, la regina delle console della passata generazione, era messa peggio, con un HW, che per chi se lo fosse dimenticato, che non era neppure in grado di usare la combinazione HDR+AA..

Per tale motivo, non ha senso dire che le console di questa generazione sono nate vecchie...quando a differenza, sempre della ps3, sono tecnologicamente all'avanguardia.

PS parlo della ps3, perchè tra le 2 pare che abbia riscosso un maggior successo, o almeno questa è la mia sensazione

Non voglio sminuire il ragionamento...ma 175W alla presa, sono circa 150W tra CPU, GPU e edram, potenze facilmente dissipabili (beh, dipende anche dalle dimensioni del chassis) .

sul cell, in effetti pare essere stato davvero un buco nell'acqua..

Cell è stato un fallimento perché era difficile da programmare. Inoltre veniva spacciato come la rivoluzione che avrebbe seppellito il PC e i suoi processori, mentre si vedeva subito (tranne per chi non capiva una mazza di architetture. E in questo forum ce ne sono stati diversi) che non fosse un processore general-purpose.

Giuro.

Ora non so come venga implementato il timing, può essere che tra 60fps e 120fps poi non cambi nulla. Risulterebbe ingiocabile.

Un altro titolo può essere DS2, se lo giochi a 60fps le armi dimezzano la loro durata. Perché hanno vincolato diverse cose ai 30fps.

Terraria bloccato a 40fps, contro i pillars lunari si sblocca fino a 60fps.

Diventa un altro gioco.

Esempi non mancano.

Devi effettuare il login per poter commentare

Se non sei ancora registrato, puoi farlo attraverso questo form.

Se sei già registrato e loggato nel sito, puoi inserire il tuo commento.

Si tenga presente quanto letto nel regolamento, nel rispetto del "quieto vivere".